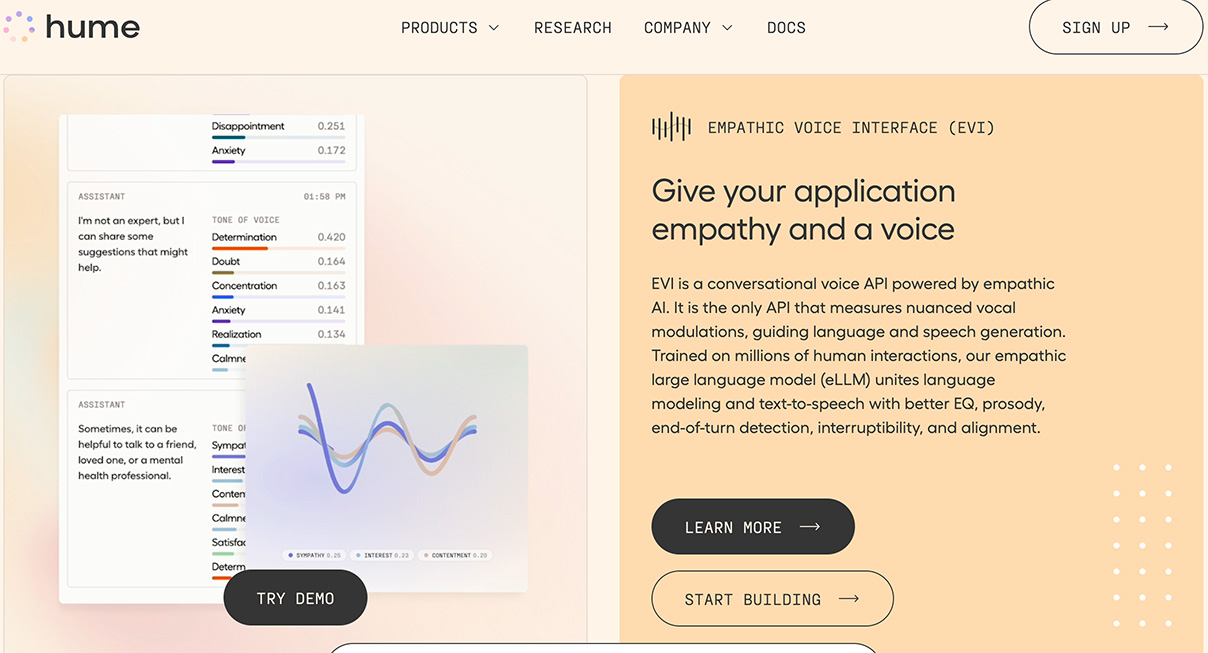

在人類交談中,透過語調的變化可以傳達比文字更豐富的意義,然而目前主流的對話式AI技術多依賴將語音轉換成文字,再根據文字內容回應,這樣的方式往往忽視了語氣等關鍵因素。新創公司Hume AI最近推出了Empathic Voice Interface(EVI),這是一種聲音AI介面,能從語音中識別談話者的情緒,並透過生成式AI技術做出適當的回應。這項技術的應用,不僅能提升AI聊天機器人的服務品質,也可用於訓練和醫療等領域。

Hume AI在推出時宣布,EVI是首個具備情緒智能的對話式AI,依據數百萬次的人類互動資料學習,能夠預測對話者的心情與偏好,並能模仿23種不同的情緒,提供最適宜的語音反應,使對話更加貼近人性。該公司強調,EVI的目標是模仿人類自然的對話方式,旨在提升AI語音體驗的核心技術。特別值得一提的是,EVI還能透過語調判斷使用者何時停止說話,並即時回應,使對話流程更加自然。

Hume AI的行政總裁兼首席科學家Alan Cowen指出,語音交流比文字打字更快且能表達更複雜的意義,他相信語音會成為人類與AI互動的首選方式。他透露,公司正在改善情緒辨識模型,比如使AI能更適當地透過笑聲表達高興,以增進用戶的滿意度。EVI的API預計將於本月推出,開發者將能將其與其他應用結合,支援ChatGPT等模型。

Hume AI同時推出了EVI的線上試用版本,使用者可以自由地與AI進行語音對話,介面會顯示對話的逐字記錄及情緒分析結果,如好奇、興奮、疲勞等,並列出該句話語中最顯著的三種情緒。記者試用後發現,該系統能適當回應談話內容和情緒;例如,若判斷使用者感到疲勞,會詢問是否睡眠不足。然而,其回應會積極地根據用戶當前的情緒進行對話,並要求用戶解釋其情緒原因。

EVI技術有望提升AI對話機器人的回應能力,適用於線上服務、用戶體驗研究及陪伴機器人等數位工具。