標籤: 爬蟲 頁1

爬蟲相關的文章,目前共收錄 25 篇內容。

Magnitude:以「視覺為先」的開源瀏覽器自動化與測試框架

Magnitude 是開源 AI 瀏覽器自動化平台,支援自然語言操作、資料擷取與 UI 測試,適用無 API 網頁流程,專為開發者與資料工程師打造。

Crawlee:高效又彈性的網頁爬蟲與自動化框架

Crawlee 是 Apify 推出的開源爬蟲與自動化工具,支援 Node.js 與 Python,整合瀏覽器模擬、反阻擋策略與代理輪替,快速打造穩定爬蟲專案。

Scraperr:免寫程式、自架網站的開源爬蟲服務

Scraperr 是 self-hosted 圖形化網頁爬蟲工具,免寫程式碼即可透過 XPath 擷取資料、管理任務,支援媒體下載與結果匯出。

AnyCrawl:Node.js/TypeScript 的高效 AI 網頁爬蟲框架

AnyCrawl 是一款開源高效網頁爬蟲工具,支援 SERP 抓取、全站遍歷與 LLM 結構化輸出,採用 Node.js 開發,支援多執行緒與 Docker 部署,適合大規模自動化資料蒐集。

WaterCrawl:AI 驅動的網站爬蟲與資料擷取平台

WaterCrawl 是專為 LLM 資料建構設計的開源爬蟲框架,支援精準擷取、AI 處理與多語言 SDK,適合需自控與透明化的技術團隊使用。

Jina AI:專為開發者設計的開源 AI 爬蟲、搜索與資訊檢索工具

Jina AI 是專注於開源神經搜索技術的公司,提供高效資訊檢索工具。主要產品包括 DeepSearch 深度檢索、Reader 網頁內容轉換、Embeddings 多模態嵌入、Reranker 搜索結果優化、Classifier 圖像與文字分類,以及 Segmenter 長文本切分,助力開發者構建多模態 AI 應用。

Scrapeless:無需寫程式,輕鬆擷取網頁資料的 AI 工具

Scrapeless 是 AI 驅動的網頁資料擷取工具,支援真實指紋模擬、AI 自動擷取、驗證碼解算與代理 IP 輪替,突破防爬機制,無需撰寫程式即可高效擷取公開網站資訊,適用於電商監控、競爭分析與商業情報收集。

Lindy:全方位個人 AI 助理,幫助你提高工作效率、簡化任務

Lindy 是一款強大的 AI 個人助理,能自動化電子郵件管理、會議記錄、時程安排、客戶服務和潛在客戶開發等日常任務。結合智能篩選與個性化操作,Lindy 可大幅提升工作效率,幫助用戶專注於高價值任務,成為職場效率提升的得力助手。

Scrapling:一款簡單高效的網頁數據擷取工具

Scrapling 是由 D4Vinci 開發的輕量化 Python 數據擷取工具,提供簡單 API 設計、多執行緒高效擷取和完善的錯誤處理,適合快速建置爬蟲任務的開發者。

Flyscrape:無代碼、自訂網頁爬蟲的高效解決方案

Flyscrape 是一款無代碼網頁數據抓取平台,用戶可在數分鐘內創建網頁抓取器,適合電商數據、評論內容和產品資訊等需求。其功能包括無代碼抓取器配置、JavaScript 渲染支持、Cookie 整合、高靈活抓取設定、jQuery 式 API 和即時結果預覽等。這款工具適合市場行銷、數據分析、內容創作和研究人員,降低技術門檻,讓非技術用戶也能輕鬆獲取並結構化數據,提升數據管理與分析效率。

MrScraper:AI 驅動的網頁數據抓取工具

MrScraper 是一款專為網頁數據抓取設計的 AI 工具,允許用戶輕鬆從任何網站提取所需數據。它支援自動化抓取,能夠通過提供網址和指令來自動提取訊息,並處理多種網頁資料格式。這個工具對於生成潛在客戶名單、提取聯絡訊息、社群資料等應用場景非常有用。MrScraper 不僅支援無代碼操作,還可以通過 API 和 Zapier 進行整合,讓數據抓取和自動化工作變得更加簡單高效。

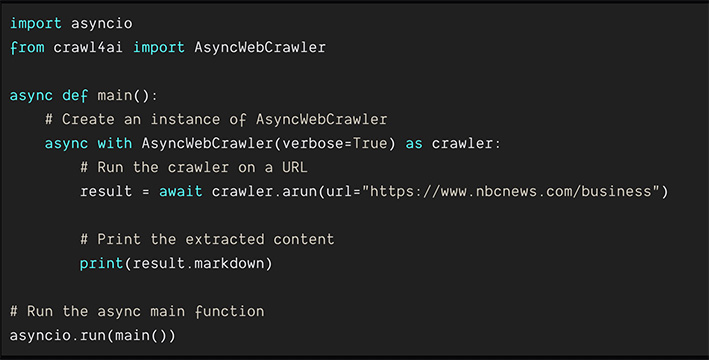

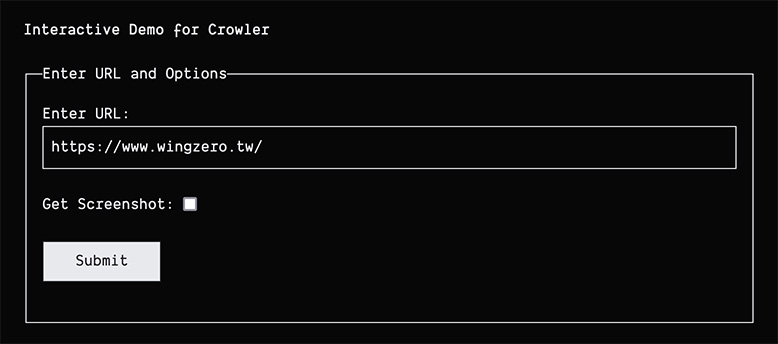

Crawl4AI:專為人工智慧訓練設計的開源網頁資料爬蟲工具

Crawl4AI 是由 unclecode 開發的開源專案,專為 AI 和 ML 訓練數據準備設計,支援自動化網頁爬取、資料清理與標註,並具備反爬蟲技術應對,適合各類 AI 應用。

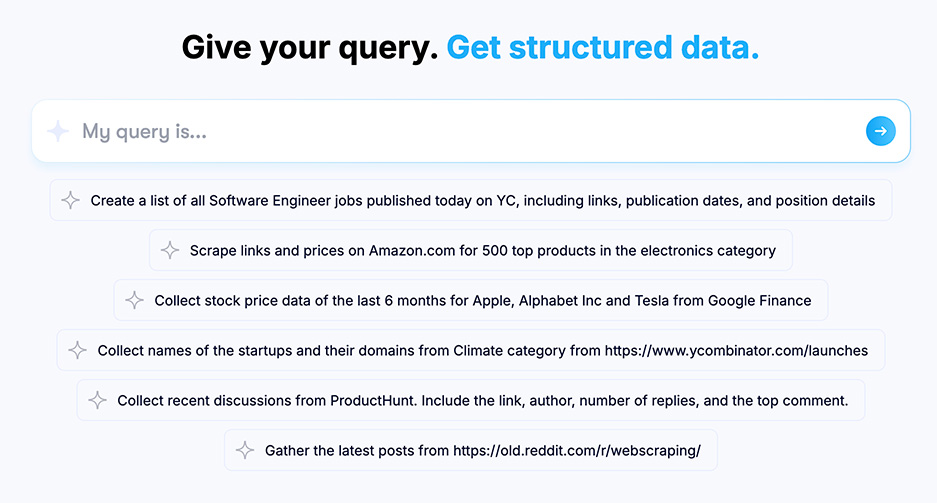

DAT.AI:自動化資料收集與結構化數據服務

DAT.AI 是一個強大的自動化資料收集平台,專為開發者及數據專家設計。用戶可以透過簡單的查詢,從各類網站上合法地收集結構化數據。無論是最新的工作機會、電子產品價格、或是股票數據,DAT.AI 都能快速抓取並整理成有用的資訊,適用於商業分析、研究及自動化工作流程。

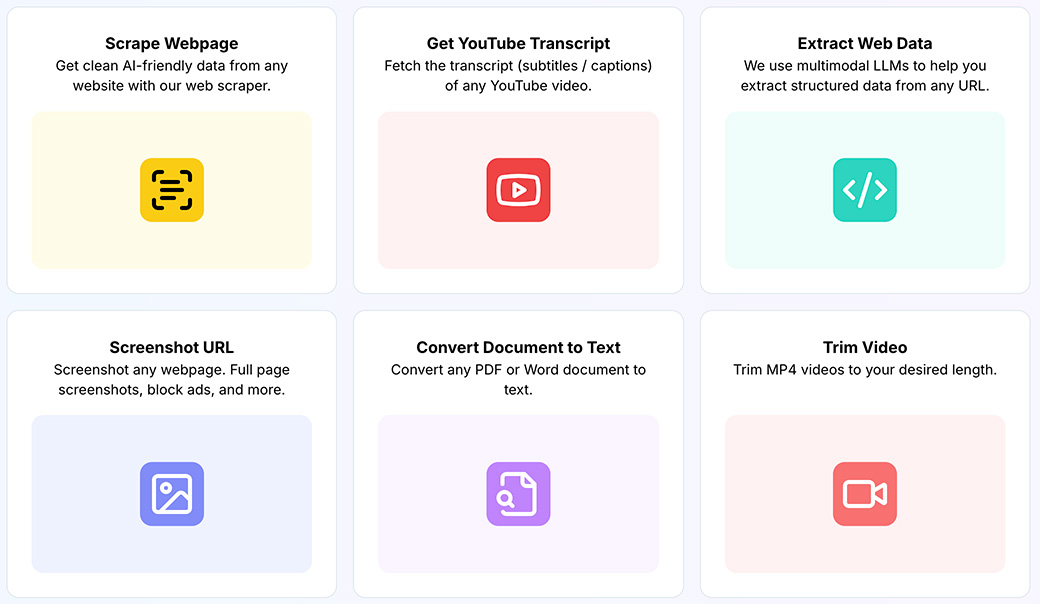

Dumpling AI:AI 自動化的無代碼工具箱

Dumpling AI 提供一個強大的無代碼工具箱,讓使用者輕鬆整合 AI 自動化功能。無需編寫程式碼,使用者可以將 Dumpling AI 應用於多個平台如 Zapier 和 Make.com,實現網頁爬取、PDF 轉換、YouTube 字幕抓取等功能。這個工具還支援地圖和新聞搜尋、影片剪輯及執行 Javascript 程式碼等。

Crawlee-Python:高效的網頁爬取和瀏覽器自動化工具

Crawlee-Python 是一款功能強大的網頁爬取和瀏覽器自動化工具庫,旨在幫助開發者建立可靠的爬蟲。此工具支援從網站中提取數據,用於 AI、大型語言模型、檢索增強生成(RAG)或 GPT 的應用,並能下載 HTML、PDF、JPG、PNG 等各種文件。Crawlee 可以與 BeautifulSoup、Playwright 和原生 HTTP 協作,支援有頭和無頭模式,以及代理輪換。

Crawl4AI:簡化網頁爬蟲與數據擷取的最佳工具

Crawl4AI 是一個開源的 Python 函式庫,專為簡化網頁爬蟲和數據擷取設計,特別適用於大型語言模型(LLMs)和 AI 應用。它提供靈活且強大的解決方案,讓用戶能夠高效地從網頁中提取有用的資訊。

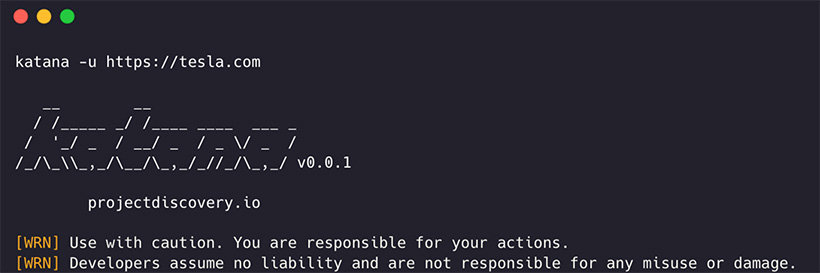

Katana:高效能的網頁爬取框架

Katana 是由 ProjectDiscovery 團隊開發的次世代網頁爬取框架,專為自動化流程中的高效執行設計。該工具提供標準模式和無頭模式,支持 JavaScript 解析、表單自動填寫、範圍控制和多種輸出格式,非常適合需要深度網頁爬取的開發者和安全研究人員。